Google Colaboratory というサービスをご存知でしょうか。

これはGoogleが教育や研究用に、

Jupyter Notebookという開発環境を誰でも簡単に利用できるようにしたものです。

つまり

Python実行環境を誰でも簡単にChromeブラウザ上に手に入れる事ができます!

さらに、コードはGoogleドライブ上に保存され共有可能です!

しかも、GPU(Tesla K80)も12時間分までなら無料で使えてしまいます!

まさに機械学習を試すにはうってつけの環境ということで、日本語の記事も増えてきているようです。

ブラウザだけでPythonが実行できてしまうGoogle Colaboratory。

今回は少しライトな使用法として、OpenCVで画像処理を試してみたいと思います。

Hello World

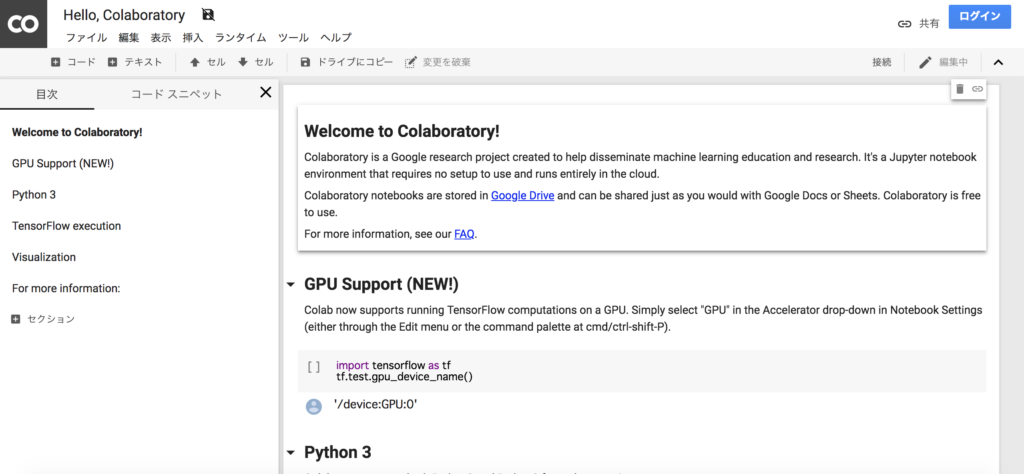

Colaboratoryのサイトにアクセスすると、次のような初期画面が表示されます。

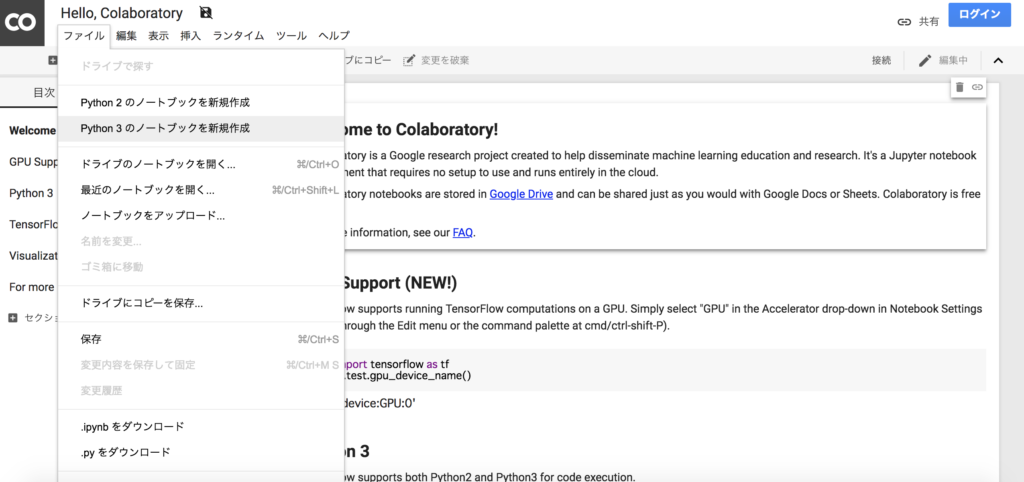

2回目以降はファイル選択画面が表示されますが、ここでは新規作成をしていきましょう。

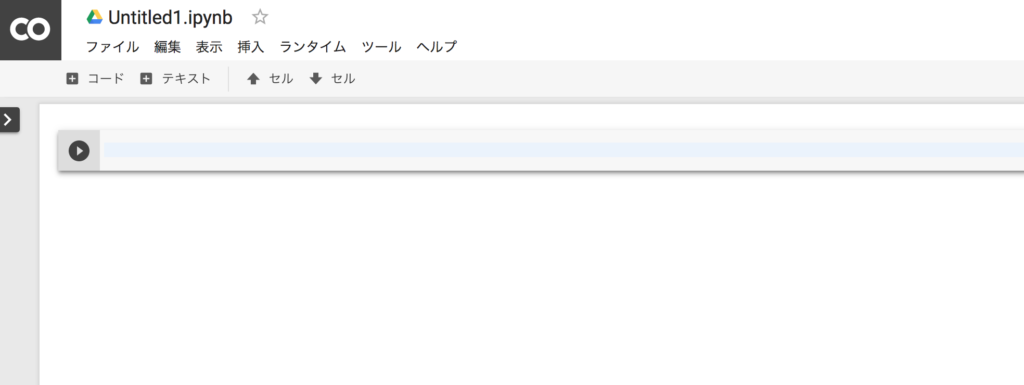

すると、以下のようなセルが表示されます。このセルにコードを書き、好きなタイミングで左の実行ボタンを押すと(またはShift+Enter)、コードが実行されます。

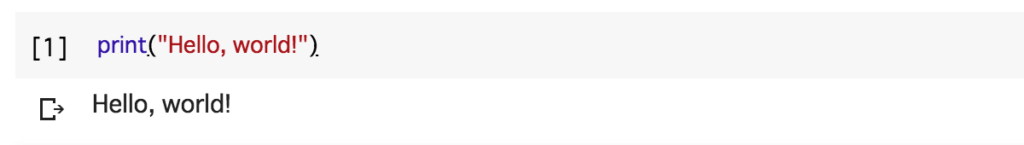

試しに以下のコードを入力して実行してみましょう。

|

1 |

print("Hello, world!") |

すると下のように実行結果がインラインで表示されます!

ファイルの読み込み

準備ができたところで、次に画像を読み込んでみましょう。

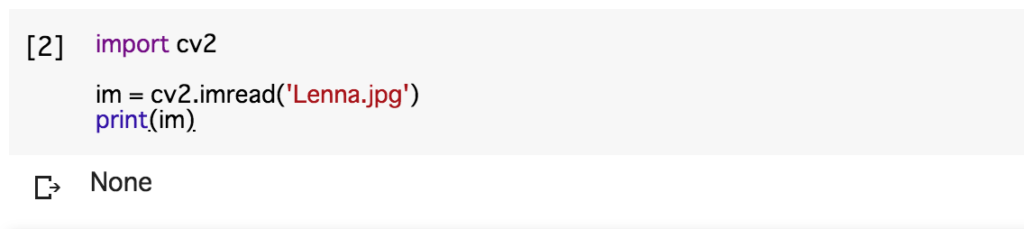

以下のコードを実行してみてください。OpenCVをimportして関数を利用します。

|

1 2 3 4 |

import cv2 im = cv2.imread('Lenna.jpg') print(im) |

おそらくエラーとなり、何も表示されないかと思います。

これは当然で、指定した画像の参照ができていないためです。

参照の方法として、Googleドライブと連携させることも可能ですが、少々手間がかかります。

今回のように数枚の参照であれば、専用のダイアログを利用するのがいいでしょう。

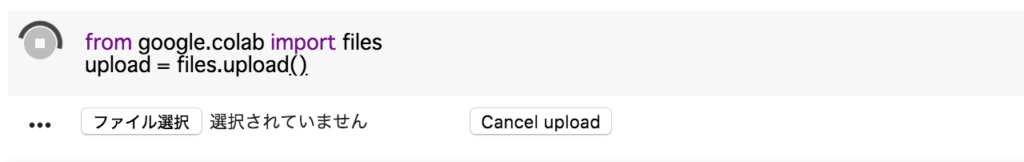

|

1 2 |

from google.colab import files upload = files.upload() |

上記のコードを実行、画像のアップを行なった後に再び先ほどのコードを実行してみてください。

エラーが解消され、画像を表す行列が表示されるはずです。

画像の表示

OpenCVで画像を表示する場合は一般的に、imshow()というメソッドを使います。しかしこれは別window上で表示するものなので、Colaboratory上ではエラーとなってしまいます。

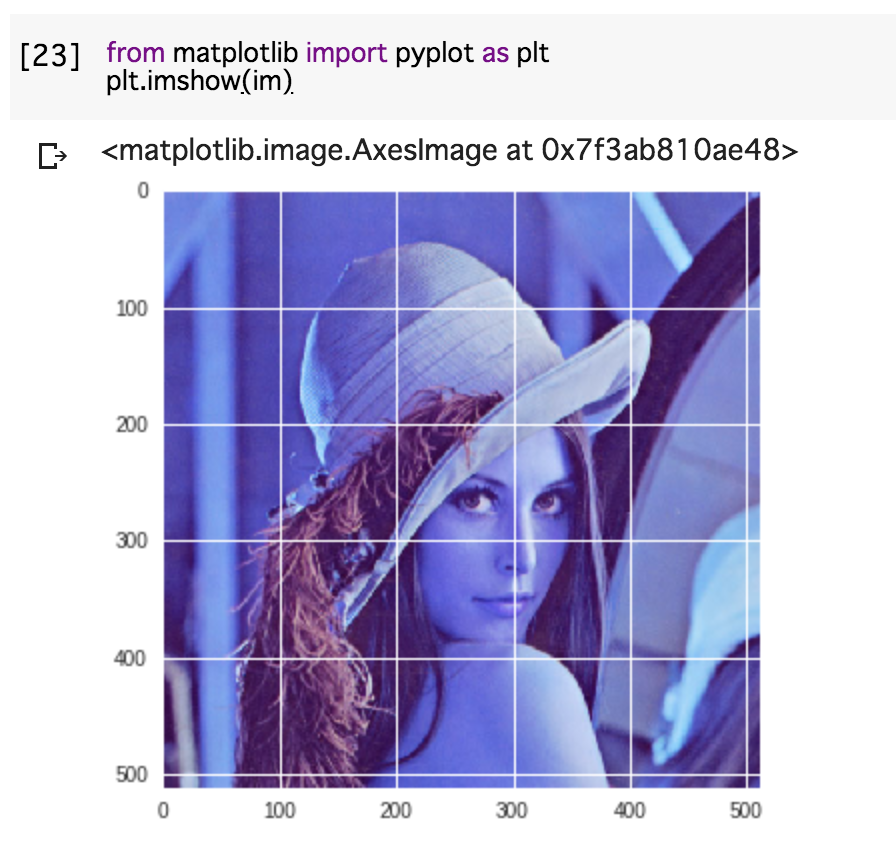

そこで表示にはmatplotlibを利用します。これは、Python&データサイエンスの分野ではデファクトスタンダードとなっているグラフ描画ライブラリです。OpenCVもですが、Colaboratoryでは有名なライブラリはデフォルトでインストールされているのでとても便利です。下記のコードを実行してみます。

|

1 2 |

from matplotlib import pyplot as plt plt.imshow(im) |

画像が表示されました。が、何か色が変です…。青い…。

これはOpenCVで扱う画像フォーマットがBGRなのに対し、matplotlibではRGBとして扱ってしまうためです。

修正して実行します。ついでに不要な軸も非表示にします。

|

1 2 3 4 |

from matplotlib import pyplot as plt plt.axis('off') im_rgb = cv2.cvtColor(im, cv2.COLOR_BGR2RGB) plt.imshow(im_rgb) |

うまくいきました。

画像処理

ここまで来れば、基本的な画像処理アルゴリズムを試すことはできると思います。

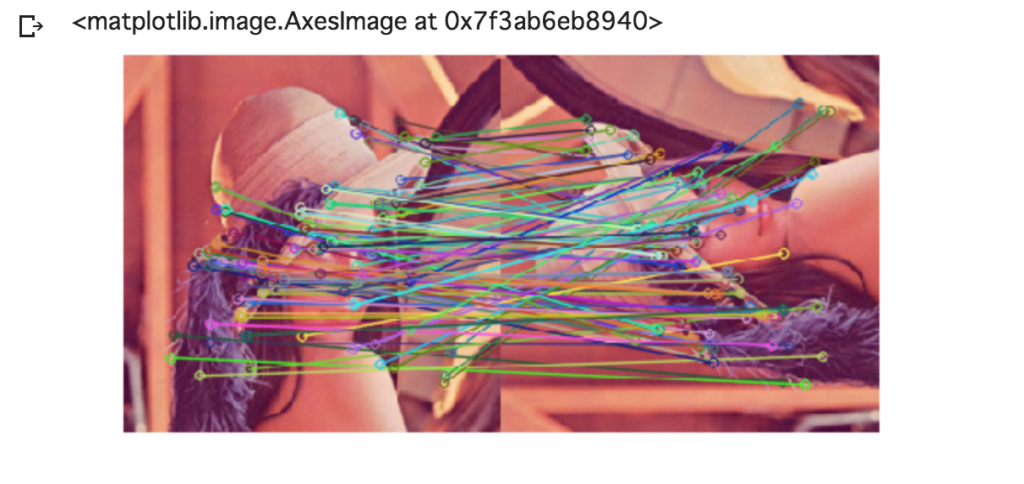

ということで最後にサンプルとして、AKAZEによる特徴点マッチングを行ってみます。

Lennaさんと、それを回転したものをマッチングします。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 |

import cv2 from matplotlib import pyplot as plt im_left = cv2.imread('Lenna.jpg') im_right = cv2.imread('LennaRotated.jpg') # ダウンサンプリング im_left_lowers = cv2.pyrDown(im_left) im_right_lowers = cv2.pyrDown(im_right) # AKAZE抽出器 detector = cv2.AKAZE_create() # 画像からKeypointとDescriptorを生成 kp_left, des_left = detector.detectAndCompute(im_left_lowers, None) kp_right, des_right = detector.detectAndCompute(im_right_lowers, None) # 全探索マッチング、上位2つの結果を採用 bf = cv2.BFMatcher() matches = bf.knnMatch(des_left, des_right, k=2) # データを間引き ratio = 0.5 good = [] for m, n in matches: if m.distance < ratio * n.distance: good.append([m]) # マッチング結果の描画 im_result = cv2.drawMatchesKnn(im_left_lowers, kp_left, im_right_lowers, kp_right, good, None, flags=2) # BGR -> RGB im_result_rgb = cv2.cvtColor(im_result, cv2.COLOR_BGR2RGB) plt.axis('off') plt.imshow(im_result_rgb) |

いかがでしょうか。

ファイルの参照は若干面倒ですが、ブラウザだけで試せるというのは素晴らしいです。

対話型で、かつGoogleドライブに残せるので、自習や勉強会の際にも大変役立ちそうです。

まだ参考となる資料が少ないですが、Jupyter Notebookの派生なので同じ解決策で事足りることも多い印象です。

この機会にぜひ Google Colaboratory、試してみてください。